Syntax:

Dahil pamilyar kami sa ChatGPT, alam namin na ang platform na ito ay pagmamay-ari ng komunidad ng Open AI at nagbibigay ito ng mga tool, arkitektura, API, at ilang mga framework na magagamit namin sa pag-deploy ng aming mga application at mga natural na modelo ng pagproseso ng wika. Ang Open AI ay nag-aalok ng mga API kung saan maaari naming gamitin ang anumang mga pre-trained na AI at NLP na mga modelo mula sa Open AI platform at maaaring gawin itong gumana para sa aming mga application tulad ng, halimbawa, upang magbigay ng mga hula sa real-time na data. Gayundin, binibigyan din ng GPT4All ang mga user nito upang isama ang mga pre-trained na AI model nito sa iba't ibang application.

Ang modelong GPT4All ay sinanay sa limitadong data kumpara sa ChatGPT. Mayroon din itong ilan sa mga hadlang sa pagganap nito kumpara sa ChatGPT ngunit pinapayagan nito ang user na gamitin ang kanilang pribadong GPT sa kanilang lokal na hardware at hindi ito nangangailangan ng anumang mga koneksyon sa network. Sa tulong ng artikulong ito, malalaman natin kung paano natin magagamit ang GPT4All na mga modelo sa Python script dahil ang GPT4All ay may opisyal na mga binding sa Python na nangangahulugan na maaari nating gamitin at isama ang GPT4All na mga modelo sa pamamagitan din ng Python script.

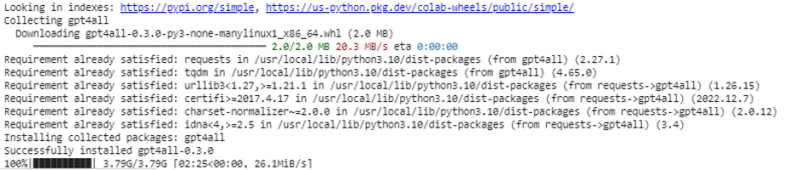

Ang lahat ay nangangailangan ng isang online na utos upang mai-install ang GPT4All para sa Python IDE. Pagkatapos, maaari naming isama ang kasing dami ng mga modelo ng AI gaya ng aming mga application. Ang utos na i-install ito ang GPT4All sa Python ay tulad ng ipinapakita sa sumusunod:

$ pip install gpt4all

Halimbawa 1:

Upang makapagsimula sa halimbawang ito, kailangan naming i-download at i-install ang Python sa aming mga system. Ang mga inirerekomendang bersyon ng Python ay 'bersyon 3.7' o ang mga sumunod sa bersyong ito. Ang isa pang paraan upang magtrabaho kasama ang Python upang maiwasan ang mahabang proseso ng pag-install ng “Python setup” sa aming mga system ay ang paggamit ng “Google Colab” na isang cloud-based na kapaligiran para sa Python. Maaari naming patakbuhin ang environment na ito sa anumang web browser at maaari naming buuin ang AI at machine learning na mga modelo. Ang mga halimbawang ipapatupad namin dito ay isinasagawa sa Google Colab.

Sinasaklaw ng halimbawang ito ang paraan ng pag-install ng GPT4All sa Python at kung paano gamitin ang mga pre-trained na modelo nito. Magsisimula tayo sa unang pag-install ng GPT4All. Para doon, ang utos na nauna naming nabanggit ay naisakatuparan. Sa pagpapatupad ng utos, ang GPT4All kasama ang mga pakete at balangkas nito ay nai-download at na-install.

Ngayon, sumulong tayo. Mula sa GPT4All, ini-import namin ang 'GPT4All'. Idinaragdag nito ang lahat ng mga pre-trained na modelo mula sa GPT4All sa proyekto. Ngayon, maaari naming gamitin ang anumang solong modelo at gawin itong gawin ang mga hula para sa aming aplikasyon. Kapag na-import na namin ang package ng GPT4All, oras na para tawagan ang function na ito at gamitin ang modelong GPT4All na nagbibigay ng output para sa 'pagkumpleto ng chat'.

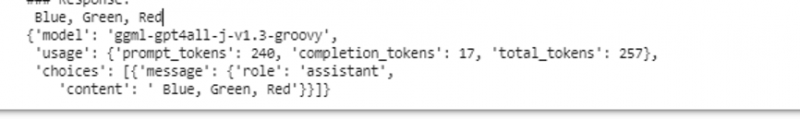

Sa madaling salita, kung hihilingin natin ang anumang bagay mula sa modelong iyon sa input, ibabalik ito sa output. Ang modelo na ginagamit namin dito ay 'ggml-gpt4all-j-v1.3-groovy'. Ang mga modelong ito ay nakaimbak na sa GPT4All cache. Makukuha natin ang mga modelong ito mula sa link na ito ' https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” para sa manu-manong pag-download. Kung ang modelo ay nasa cache na ng GPT4All, tatawagin lang namin ang pangalan ng modelo at tukuyin ito bilang mga parameter ng input sa function na 'GPT4All()'. Kung matagumpay naming na-download ito nang manu-mano, ipinapasa namin ang landas sa folder kung saan matatagpuan ang modelo. Dahil ang modelong ito ay para sa pagkumpleto ng mensahe, ang syntax para sa modelong ito ay ibinibigay bilang sumusunod:

$ Chat_completion (mga mensahe)Ang mga mensahe ay isang listahan ng diksyunaryo at ang bawat diksyunaryo ay dapat maglaman ng 'role' key na may value ng user, system, o assistant, at ang 'key' na content na may value bilang string. Sa halimbawang ito, tinukoy namin ang content bilang 'pangalanan ang tatlong kulay' at ang role key bilang 'user.'

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'user', 'content': 'Pangalanan ang 3 bulaklak'}]

Pagkatapos ng pagtutukoy na ito, tinatawag namin ang function na 'chat_completion()' kasama ang modelo. Ang code para dito ay ipinapakita sa sumusunod na output:

$ !pip i-install ang gpt4allmula sa gpt4all import GPT4All

modelo = GPT4All('ggml-gpt4all-j-v1.3-groovy')

messages = [{'role': 'user', 'content': 'Pangalanan ang tatlong kulay'}]

model.chat_completion(mensahe)

Pagkatapos ng pagpapatupad ng halimbawang ito, ang modelo ay nagbabalik ng tatlong kulay bilang tugon sa input.

Halimbawa 2:

Sinasaklaw namin ang isa pang halimbawa kung saan natuklasan namin ang isa pang paraan upang magamit ang GPT4All sa Python. Magagawa ito gamit ang mga opisyal na binding para sa Python na ibinigay ng 'Nomic' na isang open-source na komunidad ng AI, at pinapatakbo nito ang GPT4All. Gamit ang sumusunod na command, isinasama namin ang 'nomic' sa aming Python console:

$ pip install nomicKapag na-install na ito, ini-import namin ang GPT4All mula sa 'nomic.gpt4all'. Pagkatapos mag-import ng GPT4All, sinisimulan namin ang GPT4All gamit ang function na 'open()'. Pagkatapos, tinatawagan namin ang function na 'prompt()' at magpasa ng prompt sa function na ito. Pagkatapos, ang isang prompt na tugon ay nabuo batay sa prompt na ibinigay namin bilang input sa prompt na modelo.

!pip install nomicmula sa nomic.gpt4all import GPT4All

# Simulan ang modelong GPT4All

simulan = GPT4All()

initiate.open()

# Pagbuo ng tugon batay sa prompt

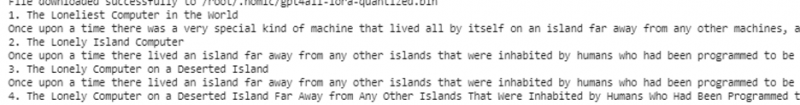

model_response = initiate.prompt('magsulat isang maikling kuwento tungkol sa isang computer)

# dispalying ang nabuong tugon

print(model_response)

Ipinapakita ng output ang agarang tugon mula sa modelong nabuo namin gamit ang pre-trained na modelong GPT4All sa Python. Kung gusto naming malaman ang higit pa tungkol sa mga modelo at kung paano namin magagamit ang mga modelong ito upang makabuo ng mga tugon, o sa simpleng salita, kung gusto naming makakuha ng kaalaman tungkol sa syntax upang makabuo ng mga tugon mula sa mga modelong ito, maaari kaming humingi ng karagdagang tulong mula sa GPT4Lahat ng mga detalye ng teknikal na dokumentasyon.

Konklusyon

Nagsusumikap pa rin ang GPT4All na makuha ang katumpakan ng pagganap. Ito ay pinapatakbo ng nomic AI platform na naglalayong magbigay ng artipisyal na matalinong mga chatbot sa mga user nito sa consumer-grade CPU dahil gumagana ang GPT4All nang walang anumang koneksyon sa network at mga GPU. Ang artikulong ito ay nagbibigay-liwanag sa amin upang mahusay na gamitin ang PyGPT4All sa isang Python na kapaligiran at upang lumikha ng isang pakikipag-ugnayan sa pagitan ng aming mga application at ang pre-trained na GPT4All AI na mga modelo. Sinasaklaw namin ang dalawang magkaibang pamamaraan kung paano i-install ang GPT4All sa Python sa gabay na ito.