Syntax:

Mayroong iba't ibang serbisyo na ibinibigay ng Hugging Face ngunit isa sa malawakang ginagamit nitong mga serbisyo ay ang 'API'. Pinapayagan ng API ang pakikipag-ugnayan ng mga pre-trained na AI at malalaking modelo ng wika sa iba't ibang mga application. Ang Hugging Face ay nagbibigay ng mga API para sa iba't ibang modelo gaya ng nakalista sa sumusunod:

- Mga modelo ng pagbuo ng teksto

- Mga modelo ng pagsasalin

- Mga modelo para sa pagsusuri ng mga damdamin

- Mga modelo para sa pagbuo ng mga virtual na ahente (matalinong chatbots)

- Pag-uuri at ang mga modelo ng regression

Tuklasin natin ngayon ang paraan para makuha ang ating personalized na inference API mula sa Hugging Face. Upang magawa ito, kailangan muna nating magsimula sa pamamagitan ng pagrerehistro sa ating sarili sa opisyal na website ng Hugging Face. Sumali sa komunidad na ito ng Hugging Face sa pamamagitan ng pag-sign up sa website na ito gamit ang iyong mga kredensyal.

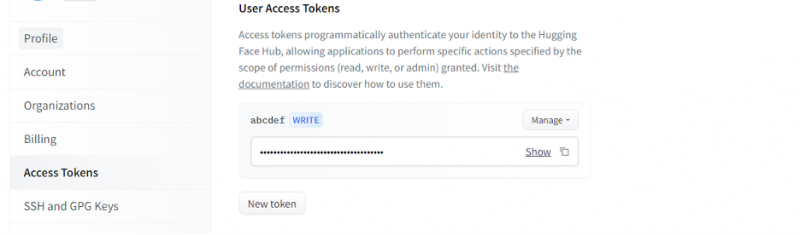

Kapag nakakuha na kami ng account sa Hugging Face, kailangan na naming humiling ng inference API. Para humiling ng API, pumunta sa mga setting ng account at piliin ang “Access Token”. Magbubukas ang isang bagong window. Piliin ang opsyong “Bagong Token” at pagkatapos ay buuin ang token sa pamamagitan ng pagbibigay muna ng pangalan ng token at ang papel nito bilang “WRITE”. Isang bagong token ang nabuo. Ngayon, dapat nating i-save ang token na ito. Hanggang sa puntong ito, mayroon tayong token mula sa Hugging Face. Sa susunod na halimbawa, makikita natin kung paano natin magagamit ang token na ito para makakuha ng inference API.

Halimbawa 1: Paano Mag-prototype gamit ang Hugging Face Inference API

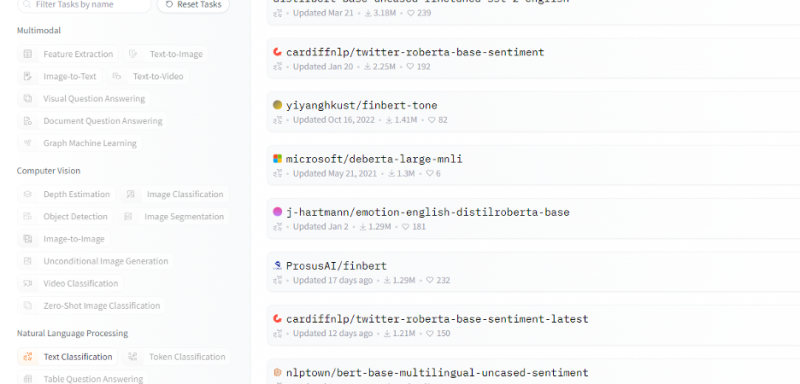

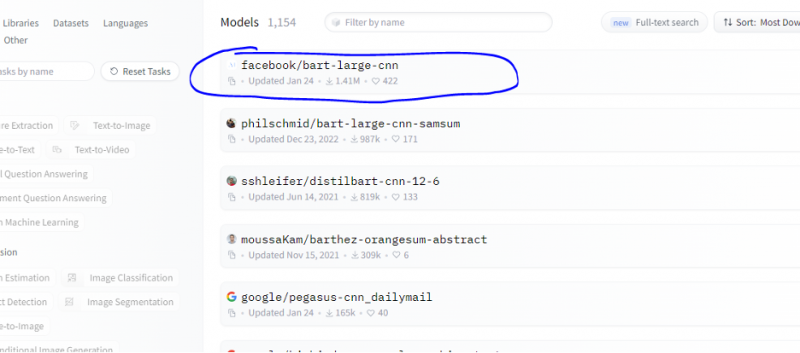

Sa ngayon, tinalakay namin ang paraan kung paano magsimula sa Hugging Face at nag-initialize kami ng token mula sa Hugging Face. Ipinapakita ng halimbawang ito kung paano namin magagamit ang bagong nabuong token na ito para makakuha ng inference API para sa isang partikular na modelo (machine learning) at gumawa ng mga hula sa pamamagitan nito. Mula sa homepage ng Hugging Face pumili ng anumang modelo na gusto mong gamitin na may kaugnayan sa iyong problema. Sabihin nating gusto naming gamitin ang pag-uuri ng teksto o ang modelo ng pagsusuri ng sentimento tulad ng ipinapakita sa sumusunod na snippet ng listahan ng mga modelong ito:

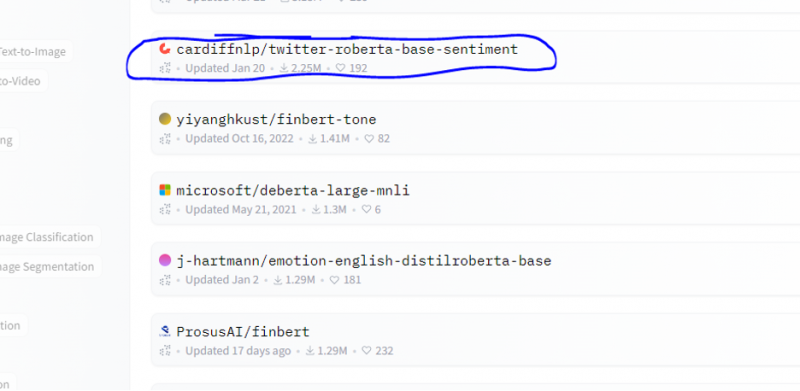

Pinipili namin ang modelo ng pagsusuri ng sentimento mula sa modelong ito.

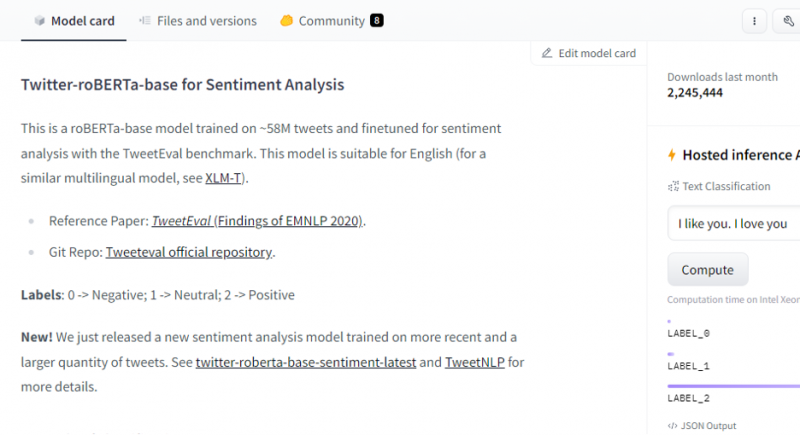

Pagkatapos piliin ang modelo, lalabas ang model card nito. Ang model card na ito ay naglalaman ng impormasyon tungkol sa mga detalye ng pagsasanay ng modelo at kung anong mga katangian ang mayroon ang modelo. Ang aming modelo ay roBERTa-base na sinanay sa 58M tweet para sa pagsusuri ng damdamin. Ang modelong ito ay may tatlong pangunahing label ng klase at ikinakategorya nito ang bawat input sa mga nauugnay na label ng klase nito.

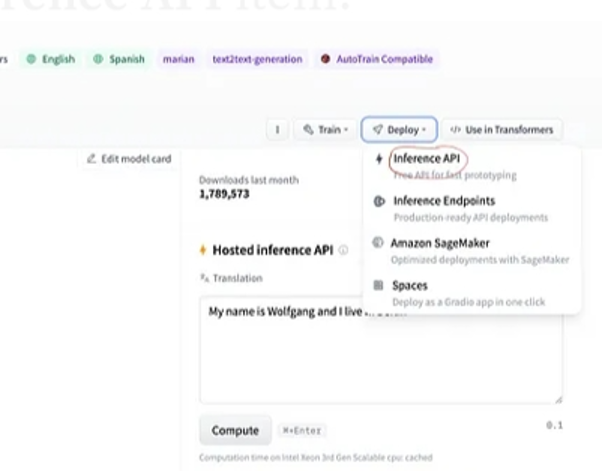

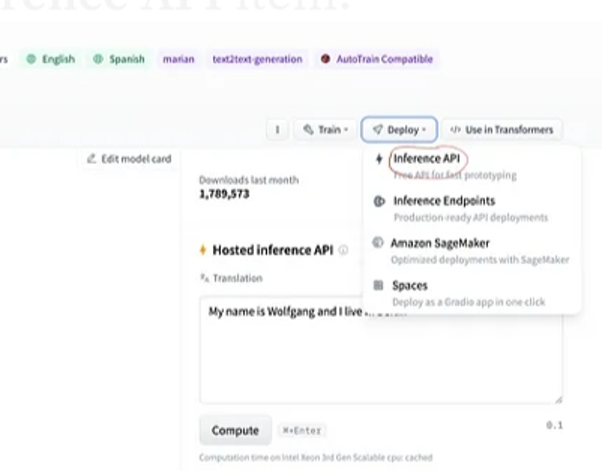

Pagkatapos ng pagpili ng modelo, kung pipiliin natin ang deployment button na nasa kanang sulok sa itaas ng window, magbubukas ito ng drop-down na menu. Mula sa menu na ito, kailangan nating piliin ang opsyong 'Inference API'.

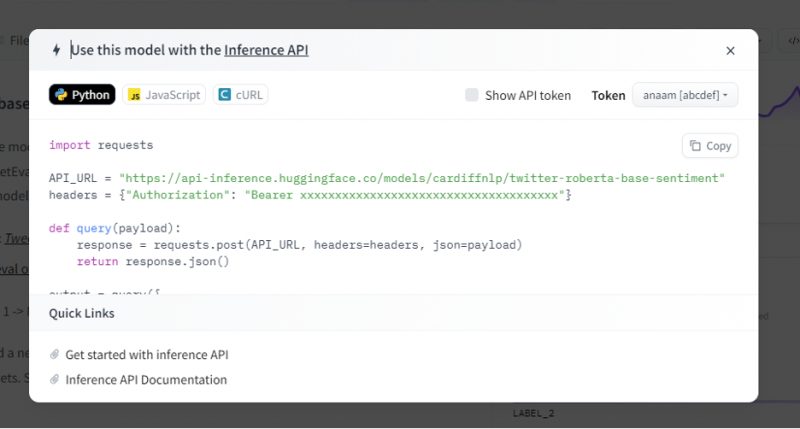

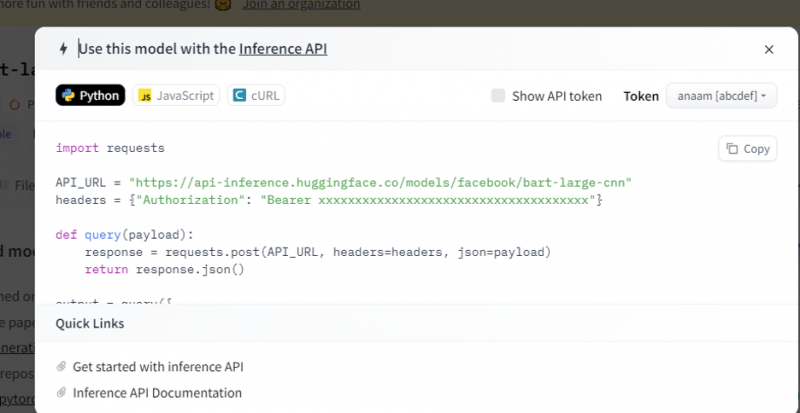

Ang inference API pagkatapos ay nagbibigay ng buong paliwanag kung paano gamitin ang partikular na modelong ito sa hinuha na ito at hinahayaan kaming mabilis na gumawa ng prototype para sa AI model. Ipinapakita ng inference API window ang code na nakasulat sa script ng Python.

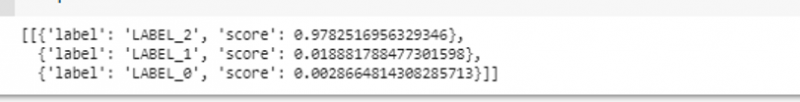

Kinokopya namin ang code na ito at i-execute ang code na ito sa alinman sa Python IDE. Ginagamit namin ang Google Colab para dito. Pagkatapos isagawa ang code na ito sa shell ng Python, nagbabalik ito ng output na kasama ng marka at hula ng label. Ibinibigay ang label at marka na ito ayon sa aming input dahil pinili namin ang modelong 'pagsusuri ng text-sentiment.' Pagkatapos, ang input na ibibigay namin sa modelo ay isang positibong pangungusap at ang modelo ay paunang sinanay sa tatlong klase ng label: ang label 0 ay nagpapahiwatig ng negatibo, ang label1 ay nagpapahiwatig ng neutral, at ang label 2 ay nakatakda sa positibo. Dahil ang aming input ay isang positibong pangungusap, ang hula ng marka mula sa modelo ay higit pa kaysa sa iba pang dalawang label na nangangahulugang hinulaan ng modelo ang pangungusap bilang isang 'positibo'.

angkat mga kahilinganAPI_URL = 'https://api-inference.huggingface.co/models/cardiffnlp/twitter-roberta-base-sentiment'

mga header = { 'Awtorisasyon' : 'Tagapagdala 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' }

def tanong ( payload ) :

tugon = mga kahilingan. post ( API_URL , mga header = mga header , json = payload )

bumalik tugon. json ( )

output = tanong ( {

'mga input' : 'Masarap ang pakiramdam ko kapag kasama kita' ,

} )

Output:

Halimbawa 2: Modelo ng Pagbubuod sa pamamagitan ng Inference

Sinusunod namin ang parehong mga hakbang na tulad ng ipinapakita sa nakaraang halimbawa at prototype ang summarization model bus gamit ang inference API nito mula sa Hugging Face. Ang modelo ng pagbubuod ay isang pre-trained na modelo na nagbubuod sa buong text na ibinibigay namin dito bilang input nito. Pumunta sa Hugging Face account, mag-click sa modelo mula sa tuktok na menu bar, at pagkatapos ay piliin ang modelo na nauugnay sa pagbubuod, piliin ito, at basahin nang mabuti ang model card nito.

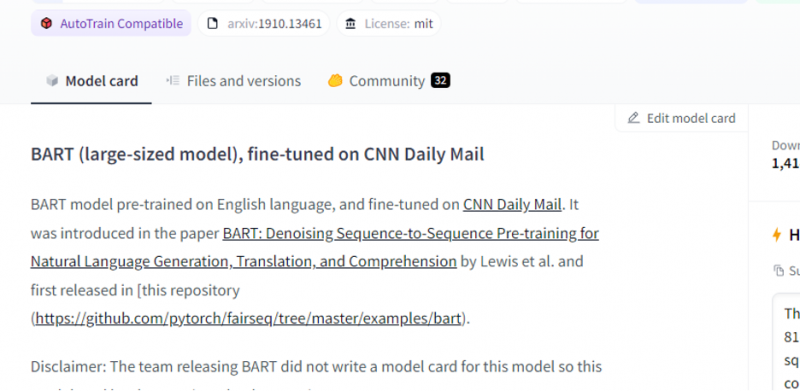

Ang modelo na aming pinili ay isang pre-trained na modelo ng BART at ito ay maayos na nakatutok sa dataset ng CNN dail mail. Ang BART ay isang modelo na halos kapareho sa modelong BERT na mayroong encoder at decoder. Ang modelong ito ay epektibo kapag ito ay maayos na nakatutok para sa pag-unawa, pagbubuod, pagsasalin, at mga gawain sa pagbuo ng teksto.

Pagkatapos, piliin ang button na 'deployment' mula sa kanang sulok sa itaas at piliin ang inference API mula sa drop-down na menu. Ang inference API ay nagbubukas ng isa pang window na naglalaman ng code at mga direksyon upang gamitin ang modelong ito sa hinuha na ito.

Kopyahin ang code na ito at isagawa ito sa isang shell ng Python.

Ibinabalik ng modelo ang output na siyang summarization ng input na ipinakain namin dito.

Konklusyon

Nagtrabaho kami sa Hugging Face Inference API at natutunan namin kung paano namin magagamit ang programmable interface ng application na ito upang gumana sa mga pre-trained na modelo ng wika. Ang dalawang halimbawa na ginawa namin sa artikulo ay pangunahing batay sa mga modelo ng NLP. Ang Hugging Face API ay maaaring gumawa ng mga kababalaghan kung gusto naming bumuo ng isang mabilis na prototype sa pamamagitan ng pagbibigay ng mabilis na pagsasama ng mga modelo ng AI sa aming mga application. Sa madaling salita, ang Hugging Face ay may mga solusyon sa lahat ng iyong problema mula sa reinforcement learning hanggang sa computer vision.