Sa blog na ito, tututukan namin ang mga paraan kung saan maaari mong pataasin ang paggamit ng GPU sa PyTorch.

Paano Taasan ang Paggamit ng GPU sa PyTorch?

Mayroong ilang mga diskarte na maaaring gamitin upang mapataas ang paggamit ng GPU at matiyak na ang pinakamahusay na mapagkukunan ng hardware ay ginagamit para sa pagproseso ng mga kumplikadong modelo ng machine-learning. Kasama sa mga taktikang ito ang pag-edit ng code at paggamit ng mga feature ng PyTorch. Ang ilang mahahalagang tip at trick ay nakalista sa ibaba:

- Naglo-load ng Data at Mga Laki ng Batch

- Mga Modelong Mas Kaunting Nakadepende sa Memorya

- PyTorch Lightning

- Ayusin ang Mga Setting ng Runtime sa Google Colab

- I-clear ang Cache para sa Optimization

Naglo-load ng Data at Mga Laki ng Batch

Ang ' Data loader ” sa PyTorch ay ginagamit upang tukuyin ang mga detalye ng data na ilo-load sa processor sa bawat forward pass ng deep learning model. Mas malaki' laki ng batch ” ng data ay mangangailangan ng higit na lakas sa pagpoproseso at tataas ang paggamit ng magagamit na GPU.

Ang syntax para sa pagtatalaga ng Dataloader na may partikular na laki ng batch sa PyTorch sa isang custom na variable ay ibinibigay sa ibaba:

Increase_GPU_Utilization = DataLoader ( batch_size = 32 )

Mga Modelong Mas Kaunting Nakadepende sa Memorya

Ang bawat arkitektura ng modelo ay nangangailangan ng iba't ibang dami ng ' alaala ” upang gumanap sa pinakamainam na antas nito. Ang mga modelo na mahusay sa paggamit ng mas kaunting memorya sa bawat yunit ng oras ay may kakayahang magtrabaho sa mga laki ng batch na mas malaki kaysa sa iba.

PyTorch Lightning

Ang PyTorch ay may pinaliit na bersyon na ' PyTorch Lightning ”. Ito ay na-optimize para sa kidlat-mabilis na pagganap tulad ng makikita mula sa pangalan nito. Gumagamit ang Lightning ng mga GPU bilang default at nag-aalok ng mas mabilis na pagproseso para sa mga modelo ng machine learning. Ang isang pangunahing bentahe ng Lightning ay ang kakulangan ng kinakailangan para sa boilerplate code na maaaring makahadlang sa pagproseso.

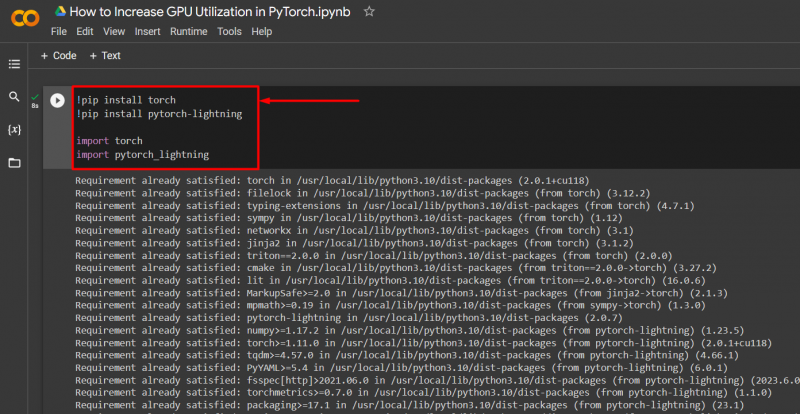

I-import ang mga kinakailangang aklatan sa isang proyekto ng PyTorch na may syntax na ibinigay sa ibaba:

! pip install torch

! pip install pytorch - kidlat

angkat tanglaw

angkat pytorch_lightning

Ayusin ang Mga Setting ng Runtime sa Google Colab

Ang Google Colaboratory ay isang cloud IDE na nagbibigay ng libreng GPU access sa mga user nito para sa pagbuo ng mga modelo ng PyTorch. Bilang default, ang mga proyekto ng Colab ay tumatakbo sa CPU ngunit maaaring baguhin ang mga setting.

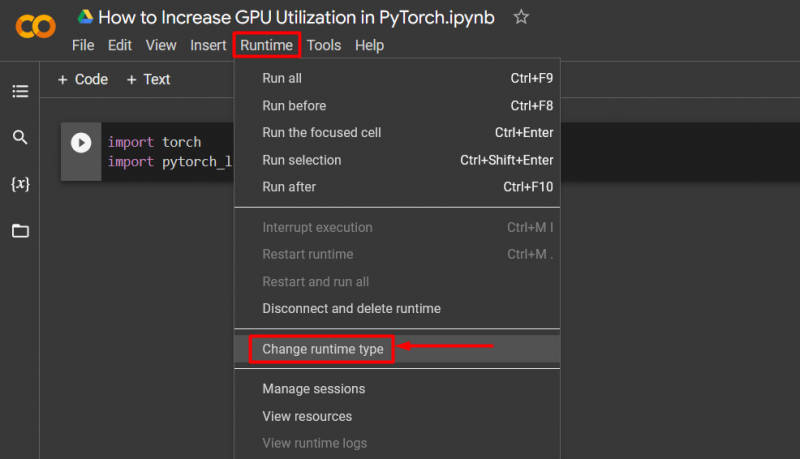

Buksan ang notebook ng Colab, pumunta sa “ Runtime ” na opsyon sa menu bar, at mag-scroll pababa sa “ Baguhin ang mga setting ng runtime ”:

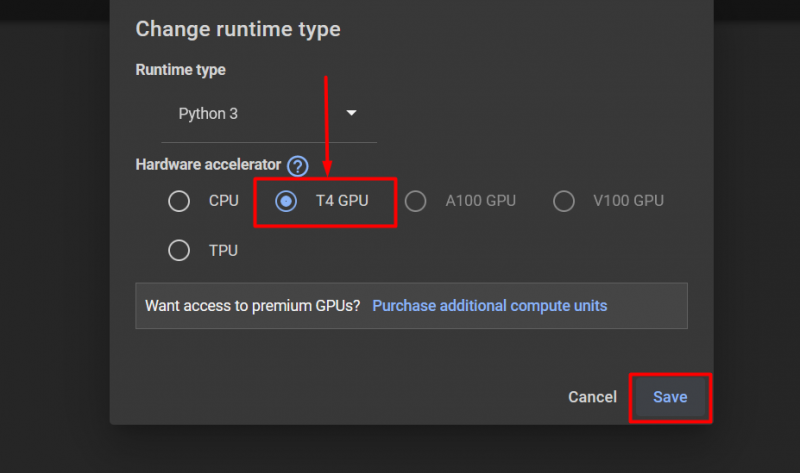

Pagkatapos, piliin ang 'T4 GPU' pagpipilian at mag-click sa ' I-save ” para ilapat ang mga pagbabago para magamit ang GPU:

I-clear ang Cache para sa Optimization

Pinapayagan ng PyTorch ang mga user nito na i-clear ang memory cache upang makapagbakante ng espasyo para sa mga bagong proseso na tumakbo. Ang ' Cache ” nag-iimbak ng data at impormasyon tungkol sa mga modelong pinapatakbo upang makatipid ito ng oras na gugugol sa pag-reload ng mga modelong ito. Ang pag-clear sa cache ay nagbibigay sa mga user ng mas maraming espasyo para magpatakbo ng mga bagong modelo.

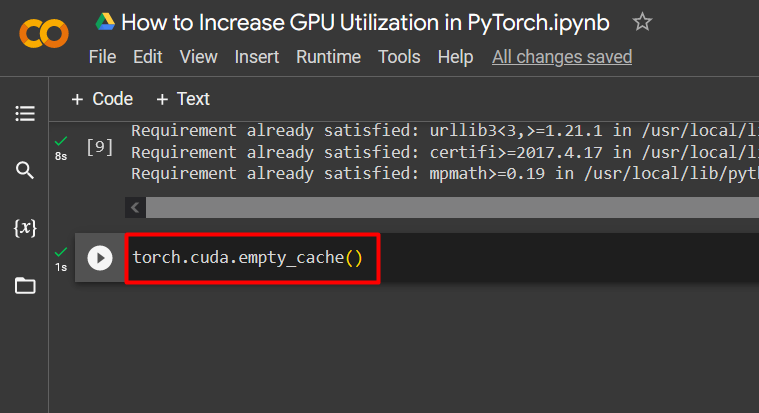

Ang command para i-clear ang GPU cache ay ibinigay sa ibaba:

tanglaw. magkaiba . empty_cache ( )

Ginagamit ang mga tip na ito para i-optimize ang pagpapatakbo ng mga modelo ng machine learning na may mga GPU sa PyTorch.

Pro-Tip

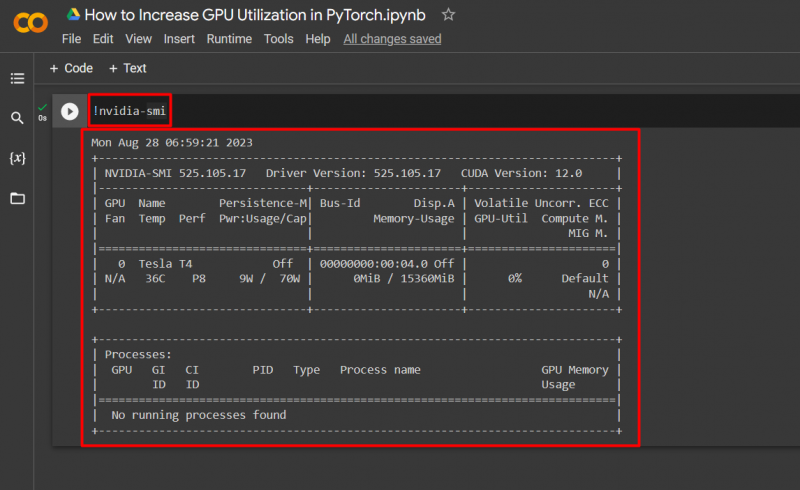

Pinapayagan ng Google Colab ang mga user nito na ma-access ang mga detalye tungkol sa paggamit ng GPU sa pamamagitan ng ' nvidia ” upang makakuha ng impormasyon kung saan ginagamit ang mga mapagkukunan ng hardware. Ang utos upang ipakita ang mga detalye ng paggamit ng GPU ay ibinigay sa ibaba:

! nvidia - smi

Tagumpay! Nagpakita lang kami ng ilang paraan para mapataas ang paggamit ng GPU sa PyTorch.

Konklusyon

Dagdagan ang paggamit ng GPU sa PyTorch sa pamamagitan ng pagtanggal ng cache, paggamit ng PyTorch Lightning, pagsasaayos ng mga setting ng runtime, paggamit ng mahusay na mga modelo, at pinakamainam na laki ng batch. Malaki ang naitutulong ng mga diskarteng ito sa pagtiyak na ang mga modelo ng malalim na pag-aaral ay gumaganap sa kanilang pinakamahusay at nakakagawa ng mga wastong konklusyon at mga hinuha mula sa magagamit na data. Ipinakita namin ang mga diskarte upang mapataas ang paggamit ng GPU.