Ang pipeline() function ay isang mahalagang bahagi ng Transformer library. Kailangan ng ilang input kung saan maaari nating tukuyin ang isang inference na gawain, mga modelo, mekanismo ng tokenization, atbp. Ang pipeline() function ay pangunahing ginagamit upang magsagawa ng mga gawain sa NLP sa isa o ilang mga text. Nagsasagawa ito ng pre-processing sa input at post-processing batay sa modelo upang makabuo ng nababasa ng tao na output at tumpak na hula na may pinakamataas na katumpakan.

Sinasaklaw ng artikulong ito ang mga sumusunod na aspeto:

- Ano ang Hugging Face Datasets Library?

- Paano Mag-apply ng Pipelines sa isang Dataset sa Hugging Face?

Ano ang Hugging Face Dataset Library?

Ang Hugging Face dataset library ay isang API na naglalaman ng ilang pampublikong dataset at nagbibigay ng madaling paraan para i-download ang mga ito. Maaaring ma-import at mai-install ang library na ito sa application sa pamamagitan ng paggamit ng “ pip ” utos. Para sa praktikal na demonstrasyon sa pag-download at pag-install ng mga dataset ng Hugging Face library, bisitahin ito Link ng Google Colab. Maaari kang mag-download ng maraming dataset mula sa Hugging Face Dataset Hub.

Matuto nang higit pa tungkol sa paggana ng pipeline() function sa pamamagitan ng pagsangguni sa artikulong ito ' Paano Gamitin ang Pipeline() Function sa Transformers? ”.

Paano Mag-apply ng Pipelines sa isang Dataset sa Hugging Face?

Nagbibigay ang Hugging Face ng ilang iba't ibang pampublikong dataset na madaling ma-install sa pamamagitan ng paggamit ng one-line code. Sa artikulong ito, makikita natin ang isang praktikal na pagpapakita ng paglalapat ng mga pipeline sa mga dataset na ito. Mayroong dalawang paraan kung saan maaaring ipatupad ang mga pipeline sa dataset.

Paraan 1: Paggamit ng Pamamaraan ng Pag-ulit

Ang pipeline() function ay maaaring umulit sa isang dataset at modelo din. Para sa layuning ito, sundin ang mga hakbang na nabanggit sa ibaba:

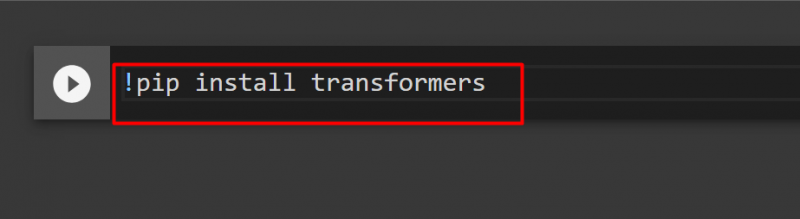

Hakbang 1: I-install ang Transformer Library

Upang i-install ang library ng Transformer, ibigay ang sumusunod na command:

!pip mag-install ng mga transformer

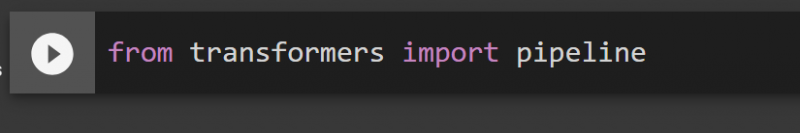

Hakbang 2: Mag-import ng Mga Pipeline

Maaari naming i-import ang pipeline mula sa Transformer library. Para sa layuning ito, ibigay ang sumusunod na utos:

mula sa mga transformer import pipeline

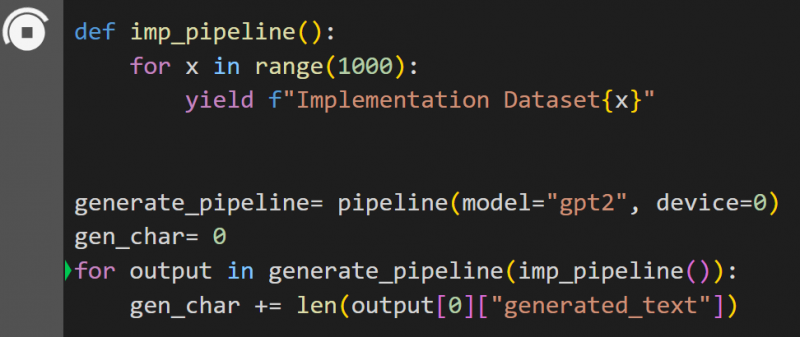

Hakbang 3: Ipatupad ang Pipeline

Dito, ang pipeline() function ay ipinatupad sa modelong “ gpt2 ”. Maaari kang mag-download ng mga modelo mula sa Hugging Face Model Hub:

def imp_pipeline():para sa x sa saklaw(1000):

magbunga ng f'Implementation Dataset{x}'

generate_pipeline= pipeline(model='gpt2', device=0)

gen_char= 0

para sa output sa generate_pipeline(imp_pipeline()):

gen_char += len(output[0]['generated_text'])

Sa code na ito, ang ' generate_pipeline ' ay isang variable na naglalaman ng pipeline() function na may modelo ' gpt2 ”. Kapag ito ay tinatawag na ' imp_pipeline() ” function, awtomatiko nitong kinikilala ang data na nadagdagan sa saklaw na tinukoy sa 1000:

Ito ay magtatagal ng ilang oras upang magsanay. Ang link sa Google Co ay binigay din.

Paraan 2: Paggamit ng Datasets Library

Sa pamamaraang ito, ipapakita namin ang pagpapatupad ng pipeline gamit ang library ng 'mga dataset':

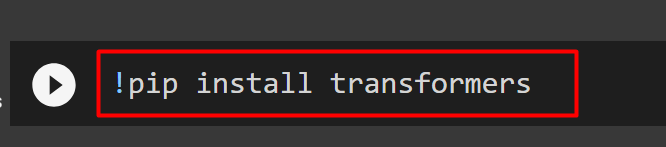

Hakbang 1: I-install ang Transformer

Upang i-install ang library ng Transformer, ibigay ang sumusunod na command:

!pip mag-install ng mga transformer

Hakbang 2: I-install ang Dataset Library

Bilang ang ' mga dataset ” ang library ay naglalaman ng lahat ng mga pampublikong dataset, maaari naming i-install ito sa pamamagitan ng paggamit ng sumusunod na command. Sa pamamagitan ng pag-install ng ' mga dataset ” library, maaari kaming direktang mag-import ng anumang dataset sa pamamagitan ng pagbibigay ng pangalan nito:

!pip mag-install ng mga dataset

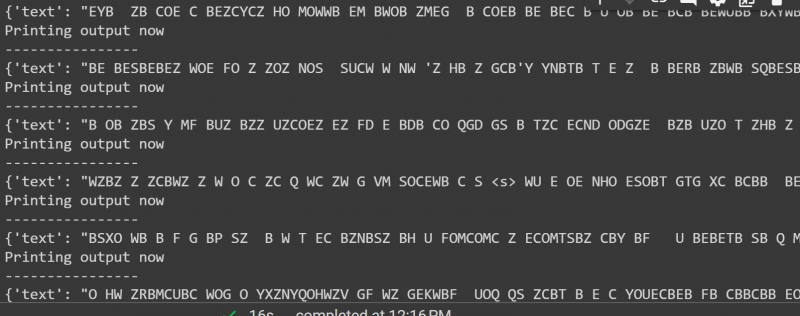

Hakbang 3: Dataset Pipeline

Upang bumuo ng pipeline sa dataset, gamitin ang sumusunod na code. Ang KeyDataset ay isang tampok na naglalabas lamang ng mga halagang iyon na interesado sa gumagamit:

mula sa transformers.pipelines.pt_utils import KeyDatasetmula sa mga transformer import pipeline

mula sa mga dataset ay nag-import ng load_dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', device=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]') para sa output sa gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('Printing output now')

print ('----------------')

print(output)

Ang output ng code sa itaas ay ibinigay sa ibaba:

Iyon ay mula sa gabay na ito. Ang link sa Google Co ay binanggit din sa artikulong ito

Konklusyon

Upang maglapat ng mga pipeline sa dataset, maaari naming i-ulit ang isang dataset sa pamamagitan ng paggamit ng pipeline() function o gamitin ang “ mga dataset ” aklatan. Ang Hugging Face ay nagbibigay ng GitHub repository link sa mga user nito para sa parehong mga dataset at modelo na magagamit batay sa mga kinakailangan. Ang artikulong ito ay nagbigay ng komprehensibong gabay sa paglalapat ng mga pipeline sa isang dataset sa Transformers.